KI wird Ihren Arzt vielleicht nicht in absehbarer Zeit ersetzen, aber es wird wahrscheinlich seine E-Mails beantworten. Eine Studie veröffentlicht in JAMA Innere Medizin Friday untersuchte Fragen von Patienten und stellte fest, dass ChatGPT in vier von fünf Fällen bessere Antworten lieferte als menschliche Ärzte. Ein Gremium aus Medizinern bewertete den Austausch und bevorzugte die Antwort der KI in 79 % der Fälle. ChatGPT lieferte nicht nur qualitativ hochwertigere Antworten, das Gremium kam zu dem Schluss, dass die KI auch einfühlsamer war. Eine Erkenntnis, die große Auswirkungen auf die Zukunft des Gesundheitswesens haben könnte.

„Es gibt einen Bereich im öffentlichen Gesundheitswesen, in dem mehr Bedarf denn je besteht, und das sind Menschen, die medizinischen Rat suchen. Die Posteingänge der Ärzte sind nach diesem Übergang zur virtuellen Versorgung aufgrund von COVID-19 bis zum Rand gefüllt“, sagte der Hauptautor der Studie, John W. Ayers, PhD, MA, stellvertretender Innovationschef an der UC San Diego School of Medicine Division of Infectious Krankheiten und globale öffentliche Gesundheit.

„Patienten-E-Mails bleiben unbeantwortet oder erhalten schlechte Antworten, und Anbieter erleiden Burnout und kündigen ihre Arbeit. Vor diesem Hintergrund dachte ich: ‚Wie kann ich in diesem Szenario helfen?’“, sagte Ayers. „Also haben wir diesen Korb mit echten Patientenfragen und echten Arztantworten bekommen und sie mit ChatGPT verglichen. Als wir das taten, gewann ChatGPT erdrutschartig.“

Fragen von Patienten sind schwer zu bekommen, aber das Team von Ayers fand eine neuartige Lösung. Die Studie stammt von Reddits r/AskDocs, wo Ärzte mit verifizierten Qualifikationen die medizinischen Fragen der Benutzer beantworten. Die Studie sammelte zufällig 195 Fragen und Antworten und ließ dann ChatGPT dieselben Fragen beantworten. Ein Gremium aus zugelassenen medizinischen Fachkräften mit einem Hintergrund in der Inneren Medizin bewertete den Austausch. Das Gremium wählte zunächst aus, welche Antwort seiner Meinung nach besser war, und bewertete dann sowohl die Qualität der Antworten als auch die Empathie oder das Verhalten am Krankenbett.

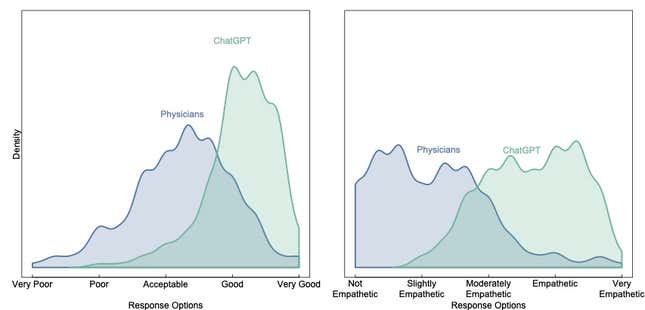

Die Ergebnisse waren dramatisch. Die Antworten von ChatGPT wurden mehr als dreimal häufiger mit „gut“ oder „sehr gut“ bewertet als die Antworten von Ärzten. Fast 10-mal häufiger wurde die KI als „empathisch“ oder „sehr empathisch“ bewertet.

Die Autoren der Studie sagen, dass ihre Arbeit kein Argument für ChatGPT gegenüber anderen KI-Tools ist, und sie sagen, dass wir noch nicht genug über die Risiken und Vorteile für Ärzte wissen, um mit der Verwendung von Chatbots zu beginnen.

„Für einige Patienten könnte dies ihr Leben retten“, sagte Ayers. Wenn bei Ihnen beispielsweise Herzinsuffizienz diagnostiziert wird, ist es wahrscheinlich, dass Sie innerhalb von fünf Jahren sterben werden. „Aber wir wissen auch, dass Ihre Überlebenswahrscheinlichkeit höher ist, wenn Sie sich in hohem Maße an klinische Ratschläge halten, wie z. B. die Einschränkung der Salzaufnahme und die Einnahme Ihrer Rezepte. In diesem Szenario könnten Nachrichten dazu beitragen, die Einhaltung dieser Ratschläge sicherzustellen.“

Die Studie sagt, dass die medizinische Gemeinschaft mit Vorsicht vorgehen muss. Die KI schreitet mit erstaunlicher Geschwindigkeit voran, und mit dem Fortschritt der Technologie steigen auch die potenziellen Schäden.

„Die Ergebnisse sind faszinierend, wenn nicht sogar überraschend, und werden sicherlich weitere dringend benötigte Forschung anregen“, sagte Steven Lin, MD, Executive Director des AI Applied Research Teams von Stanford Healthcare. Lin betonte jedoch, dass die JAMA-Studie alles andere als endgültig sei. Beispielsweise spiegeln die auf Reddit ausgetauschten Antworten nicht die typische Arzt-Patienten-Beziehung in einem klinischen Umfeld wider, und Ärzte ohne therapeutische Beziehung zu einem Patienten haben keinen besonderen Grund, in ihren Antworten einfühlsam oder persönlich zu sein. Die Ergebnisse können auch verzerrt sein, weil die Methodik zur Beurteilung von Qualität und Empathie, neben anderen Einschränkungen, zu einfach war.

Dennoch sagte Lin, dass die Studie ermutigend sei und die enorme Chance hervorhebe, die Chatbots für die öffentliche Gesundheit darstellen.

„Es gibt ein enormes Potenzial für Chatbots, Ärzten beim Versenden von Nachrichten an Patienten zu helfen, indem sie auf der Grundlage einer Patientenanfrage eine Nachricht verfassen, die Ärzte oder andere Mitglieder des klinischen Teams bearbeiten können“, sagte echtes, verheerendes Problem.“

Ärzte fingen fast sofort nach der Veröffentlichung an, mit ChatGPT herumzuspielen, und der Chatbot zeigt viel Potenzial für den Einsatz im Gesundheitswesen. Aber es ist schwer, den Antworten der KI zu vertrauen, weil sie in einigen Fällen lügt. In einem anderen Kürzlich durchgeführte Studie, ließen Forscher ChatGPT Fragen zur Vorbeugung von Herz-Kreislauf-Erkrankungen beantworten. Die KI gab angemessene Antworten auf 21 von 25 Fragen. Aber ChatGPT hat einige schwerwiegende Fehler gemacht, wie z. B. Cardio und Gewichtheben „nachdrücklich zu empfehlen“, was für manche Menschen unsicher sein kann. In einem anderen Beispiel hat ein Arzt ein TikTok über ein Gespräch mit ChatGPT wo gepostet es bildete eine medizinische Studie. Diese Probleme könnten tödliche Folgen haben, wenn Patienten den Rat eines Roboters befolgen, ohne einen echten Arzt zu kontaktieren. OpenAI, der Hersteller von ChatGPT, hat auf eine Bitte um Stellungnahme nicht geantwortet.

„Wir sagen nicht, dass wir einfach den Schalter umlegen und das umsetzen sollten. Wir müssen pausieren und die Phase-1-Studien durchführen, um die Vorteile zu bewerten und die potenziellen Schäden zu entdecken und zu mindern.“ sagte Ayers. „Das bedeutet nicht, dass wir die Umsetzung um Jahre hinauszögern müssen. Sie könnten die nächste Phase und das nächste erforderliche Studium innerhalb weniger Monate absolvieren.“

Es steht außer Frage, dass Tools wie ChatGPT ihren Weg in die Welt der Medizin finden werden. Es hat bereits begonnen. Im Januar, ein Der psychiatrische Dienst namens Koko testete GPT-3 auf 4.000 Menschen. Die Plattform verbindet Benutzer, um Peer-to-Pier-Support bereitzustellen, und lässt die Benutzer kurz einen OpenAI-gestützten Chatbot in ihren Antworten nutzen. Koko sagte, die KI-Nachrichten hätten eine überwältigend positive Resonanz erhalten, aber das Unternehmen habe das Experiment nach ein paar Tagen eingestellt, weil es sich „irgendwie steril anfühlte“.

Das heißt nicht, dass Tools wie ChatGPT in diesem Zusammenhang kein Potenzial haben. Richtig entworfen, ein System, das verwendet KI-Chatbots in der Medizin „könnte sogar ein Instrument zur Bekämpfung der Epidemie von Fehlinformationen und Desinformationen sein, die heute wahrscheinlich die größte Einzelbedrohung für die öffentliche Gesundheit darstellen“, sagte Lin. „Schlecht angewendet, kann es Fehlinformationen und Desinformationen noch weit verbreiteter machen.“

Liest man sich die Daten der JAMA-Studie durch, erscheinen die Ergebnisse auch für Laien eindeutig. Ein Mann sagte zum Beispiel, er bekomme Armschmerzen, wenn er niest, und fragte, ob das Grund zur Besorgnis sei. Der Arzt antwortete: „Im Grunde nein.“ ChatGPT gab eine detaillierte Antwort mit fünf Absätzen mit möglichen Ursachen für die Schmerzen und mehreren Empfehlungen, darunter:

„Es ist nicht ungewöhnlich, dass Menschen nach dem Niesen Muskelschmerzen oder Schmerzen in verschiedenen Körperteilen haben. Niesen ist ein plötzlicher, kraftvoller Reflex, der Muskelkontraktionen im ganzen Körper verursachen kann. In den meisten Fällen sind Muskelschmerzen oder -beschwerden nach dem Niesen vorübergehend und kein Grund zur Sorge. Wenn der Schmerz jedoch stark ist oder über einen längeren Zeitraum anhält, ist es ratsam, einen Arzt zur weiteren Beurteilung zu konsultieren.“

Es überrascht nicht, dass alle Diskussionsteilnehmer in der Studie die Antwort von ChatGPT bevorzugten. (Gizmodo hat die Details im obigen Beispiel des Arztes leicht bearbeitet, um die Privatsphäre zu schützen.)

„Das bedeutet nicht, dass wir Ärzte aus dem Bild werfen sollten“, sagte Ayers. „Aber der ideale Kandidat, der Nachrichten generiert, könnte ein Arzt sein, der ein KI-System verwendet.“

Wenn (und zwangsläufig wann) ChatGPT anfängt, Ärzten mit ihren E-Mails zu helfen, könnte es nützlich sein, auch wenn es keine medizinische Beratung bietet. Mithilfe von ChatGPT könnten Ärzte schneller arbeiten und Patienten die benötigten Informationen geben, ohne sich um Grammatik und Rechtschreibung kümmern zu müssen. Ayers sagte, ein ChatBot könne auch dazu beitragen, Patienten proaktiv mit Empfehlungen zur Gesundheitsversorgung zu erreichen – wie es viele Ärzte in den frühen Stadien der Pandemie taten – anstatt darauf zu warten, dass Patienten sich melden, wenn sie ein Problem haben.

„Dies wird nicht nur die Medizin verändern und Ärzten helfen, es wird einen enormen Wert für die öffentliche Gesundheit haben, wir sprechen massenhaft in der gesamten Bevölkerung“, sagte Ayers.

Möchten Sie mehr über KI, Chatbots und die Zukunft des maschinellen Lernens erfahren? Schauen Sie sich unsere vollständige Berichterstattung über an künstliche Intelligenzoder stöbern Sie in unseren Leitfäden zu Die besten kostenlosen KI-Kunstgeneratoren Und Alles, was wir über ChatGPT von OpenAI wissen.