Stability AI, das Startup hinter dem generativen KI-Kunsttool Stable Diffusion, hat heute eine Open-Source-Suite von textgenerierenden KI-Modellen veröffentlicht, die mit Systemen wie GPT-4 von OpenAI konkurrieren sollen.

Genannt StableLM und verfügbar in „Alpha“ auf GitHub und Gesicht umarmeneiner Plattform zum Hosten von KI-Modellen und Code, sagt Stability AI, dass die Modelle sowohl Code als auch Text generieren und „zeigen können, wie kleine und effiziente Modelle mit entsprechendem Training eine hohe Leistung erbringen können“.

„Sprachmodelle werden das Rückgrat unserer digitalen Wirtschaft bilden, und wir möchten, dass jeder bei ihrem Design eine Stimme hat“, schrieb das Stability AI-Team in a Blogeintrag auf der Firmenseite.

Die Modelle wurden mit einem Datensatz namens „The Pile“ trainiert, einer Mischung aus im Internet gescrapten Textbeispielen von Websites wie PubMed, StackExchange und Wikipedia. Aber Stability AI behauptet, dass es ein benutzerdefiniertes Trainingsset erstellt hat, das die Größe des Standardstapels um das Dreifache erweitert.

Bildnachweis: Stabilität KI

Stability AI hat in dem Blogbeitrag nicht gesagt, ob die StableLM-Modelle unter den gleichen Einschränkungen leiden wie andere, nämlich eine Tendenz, giftige Antworten auf bestimmte Eingabeaufforderungen zu erzeugen und Fakten zu halluzinieren (dh zu erfinden). Aber angesichts der Tatsache, dass The Pile eine profane, anzügliche und ansonsten ziemlich aggressive Sprache enthält, wäre es nicht überraschend, wenn dies der Fall wäre.

Dieser Reporter hat versucht, die Modelle auf Hugging Face zu testen, das ein Frontend bereitstellt, um sie auszuführen, ohne den Code von Grund auf neu konfigurieren zu müssen. Leider bekam ich jedes Mal einen „Auslastung“-Fehler, der mit der Größe der Modelle – oder ihrer Beliebtheit – zu tun haben könnte.

„Wie es für alle vortrainierten großen Sprachmodelle ohne zusätzliche Feinabstimmung und bestärkendes Lernen typisch ist, können die Antworten, die ein Benutzer erhält, von unterschiedlicher Qualität sein und möglicherweise anstößige Sprache und Ansichten enthalten“, schrieb Stability AI im Repo für StableLM. „Dies wird voraussichtlich durch Skalierung, bessere Daten, Community-Feedback und Optimierung verbessert.“

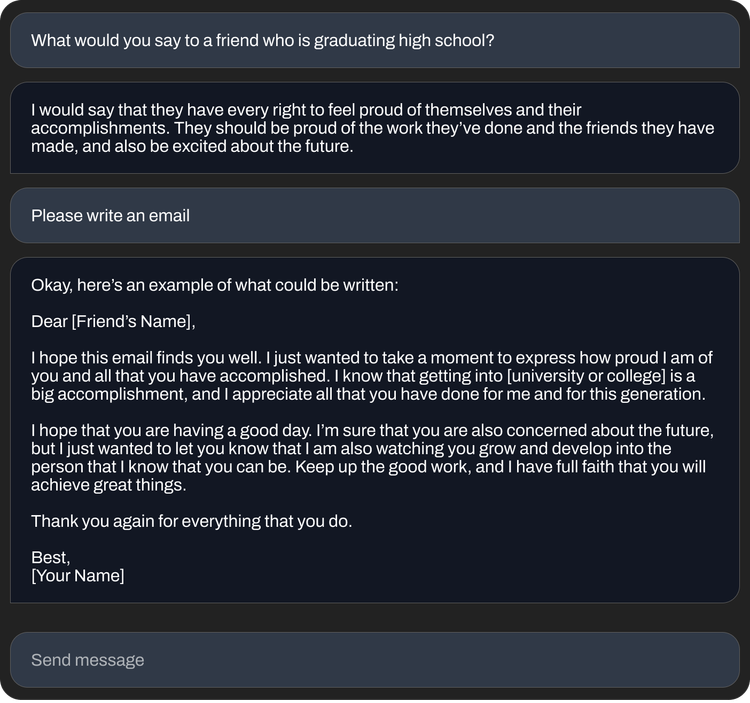

Dennoch scheinen die StableLM-Modelle in Bezug auf das, was sie leisten können, ziemlich leistungsfähig zu sein – insbesondere die fein abgestimmten Versionen, die in der Alpha-Version enthalten sind. Die fein abgestimmten StableLM-Modelle, die mit einer von Stanford entwickelten Technik namens Alpaca auf Open-Source-Datensätzen, einschließlich des KI-Startups Anthropic, abgestimmt wurden, verhalten sich wie ChatGPT und reagieren auf Anweisungen (manchmal mit Humor) wie „Schreiben Sie ein Anschreiben für einen Softwareentwickler“. oder „Texte für einen epischen Rap-Battle-Song schreiben“.

Die Zahl der Open-Source-Textgenerierungsmodelle wächst praktisch von Tag zu Tag, da große und kleine Unternehmen um Sichtbarkeit im zunehmend lukrativen Bereich der generativen KI kämpfen. Im vergangenen Jahr haben Meta, Nvidia und unabhängige Gruppen wie das von Hugging Face unterstützte BigScience-Projekt Modelle veröffentlicht, die in etwa mit „privaten“, über eine API verfügbaren Modellen wie GPT-4 und Claude von Anthropic vergleichbar sind.

Einige Forscher haben in der Vergangenheit die Veröffentlichung von Open-Source-Modellen nach dem Vorbild von StableLM kritisiert und argumentiert, dass sie für unappetitliche Zwecke wie das Erstellen von Phishing-E-Mails oder die Unterstützung von Malware-Angriffen verwendet werden könnten. Aber Stability AI argumentiert, dass Open-Sourcing tatsächlich der richtige Ansatz ist.

„Wir öffnen unsere Modelle, um Transparenz zu fördern und Vertrauen zu schaffen. Forscher können ‚unter die Haube schauen‘, um die Leistung zu überprüfen, an Interpretierbarkeitstechniken arbeiten, potenzielle Risiken identifizieren und bei der Entwicklung von Sicherheitsvorkehrungen helfen“, schrieb Stability AI in dem Blogbeitrag. „Der offene, differenzierte Zugang zu unseren Modellen ermöglicht es der breiten Forschungs- und akademischen Gemeinschaft, Interpretierbarkeits- und Sicherheitstechniken zu entwickeln, die über das hinausgehen, was mit geschlossenen Modellen möglich ist.“

Bildnachweis: Stabilität KI

Daran mag etwas Wahres sein. Sogar von Toren geschützte, kommerzialisierte Modelle wie GPT-4, die über Filter und menschliche Moderationsteams verfügen, haben sich bewährt Toxizität. Andererseits erfordern Open-Source-Modelle mehr Aufwand, um das Backend zu optimieren und zu reparieren – insbesondere, wenn Entwickler nicht mit den neuesten Updates Schritt halten.

Auf jeden Fall hat sich die Stabilitäts-KI historisch gesehen nicht vor Kontroversen gescheut.

Das Unternehmen ist im Fadenkreuz von legal Fälle die behaupten, dass es die Rechte von Millionen von Künstlern verletzt habe, indem es KI-Kunstwerkzeuge unter Verwendung von webgekratzten, urheberrechtlich geschützten Bildern entwickelt habe. Und einige Communities im Internet haben die Tools von Stability angezapft, um pornografische Deepfakes von Prominenten und grafische Darstellungen von Gewalt zu erstellen.

Darüber hinaus, trotz des philanthropischen Tons seines Blogbeitrags, Stability AI steht auch unter dem Druck, seine weitläufigen Bemühungen zu monetarisieren – die die gesamte Bandbreite von Kunst und Animation bis hin zu biomediertem und generativem Audio abdecken. Stabilität AI CEO Emad Mostaque hat angedeutet bei Plänen zum Börsengang, aber Semafor vor kurzem gemeldet dass Stability AI – das im vergangenen Oktober über 100 Millionen US-Dollar an Risikokapital bei einer gemeldeten Bewertung von mehr als 1 Milliarde US-Dollar aufbrachte – „Barmittel verbrennt und nur langsam Einnahmen generiert“.