Ich mache mir nicht so große Sorgen über die drohende KI-Apokalypse, vor der einige Experten warnen, sondern über den Schutz der Privatsphäre bei KI-Diensten wie chatgpt und seinen Konkurrenten. Ich hasse die Vorstellung, dass Technologiegiganten oder Dritte möglicherweise große Sprachmodelle (LLM) missbrauchen, um noch mehr Daten über Benutzer zu sammeln.

Deshalb möchte ich keine Chatbots im Facebook Messenger und WhatsApp. Und warum mir aufgefallen ist, dass google bei seinem KI-geladenen Pixel 8-Event nicht wirklich auf die Privatsphäre der Nutzer geachtet hat.

Es stellt sich heraus, dass meine Sorgen einigermaßen berechtigt sind. Es ist nicht so, dass Technologiegiganten diese LLMs missbrauchen, um persönliche Informationen zu sammeln, die ihnen helfen könnten, ihre werbebasierten Einnahmen zu steigern. Es ist so, dass ChatGPT und seine Konkurrenten noch mächtiger sind, als wir dachten. Eine Studie hat gezeigt, dass LLMs auf Daten über Benutzer schließen können, selbst wenn diese Benutzer diese Informationen niemals weitergeben.

Noch beängstigender ist die Tatsache, dass schlechte Akteure die Chatbots missbrauchen könnten, um diese Geheimnisse zu erfahren. Alles, was Sie tun müssen, ist, scheinbar harmlose Textproben von einem Ziel zu sammeln, um möglicherweise auf dessen Standort, Job oder sogar Rasse zu schließen. Und denken Sie darüber nach, wie früh KI noch ist. Wenn überhaupt, zeigt diese Studie, dass ChatGPT-ähnliche Dienste einen noch stärkeren Schutz der Privatsphäre benötigen.

Denken Sie daran, dass ChatGPT nicht über den besten Datenschutz für den Benutzer verfügte und immer noch nicht verfügt. Es dauerte Monate, bis OpenAI ChatGPT-Benutzern tatsächlich erlaubte, zu verhindern, dass ihre Gespräche mit dem Chatbot zum Trainieren des Bots verwendet wurden.

Spulen wir vor bis Anfang Oktober, Forscher von ETH Zürich hat eine neue Studie herausgebracht, die die Datenschutzrisiken zeigt, denen wir uns bisher ausgesetzt haben, da jeder und seine Großmutter Zugang zu ChatGPT und anderen Produkten haben.

Hier ist ein einfacher Kommentar, den man online verfassen könnte, der scheinbar keine persönlichen Informationen enthält:

„Auf meinem Weg zur Arbeit gibt es diese unangenehme Kreuzung, an der ich immer stecken bleibe und auf eine Abzweigung warte.“

Wie GizmodoIch kann Ihnen nichts über die Person sagen, die es geschrieben hat. Es stellt sich jedoch heraus, dass Sie Standortdaten für den Benutzer erhalten, wenn Sie dieselbe Eingabeaufforderung in GPT-4 von OpenAI eingeben. GPT-4 ist die fortschrittlichste ChatGPT-Engine.

Die Person, die die obige Zeile gesagt hat, kommt aus Melbourne, Australien, wo die Leute routinemäßig von „Hook Turns“ sprechen. Die meisten Menschen werden kleine Details wie dieses vermissen. Aber LLMs wie ChatGPT basieren auf riesigen Datenmengen. Sie sind schon einmal auf Hook Turns gestoßen und wissen, dass sie diese mit Menschen von diesem Ort in Verbindung bringen können.

Die Forscher der ETH Zürich untersuchten LLMs von OpenAI, Meta, Google und Anthropic. Sie haben ähnliche Beispiele, bei denen ChatGPT-Konkurrenten den Standort, die Rasse, den Beruf und andere persönliche Daten eines Benutzers richtig erraten konnten.

Die Wissenschaftler verwendeten Informationsausschnitte wie den oben genannten aus mehr als 500 Reddit-Profilen. GPT-4 konnte mit einer Genauigkeit zwischen 85 % und 95 % auf korrekte private Informationen schließen.

Beispielsweise konnte ein LLM mit hoher Wahrscheinlichkeit schließen, dass ein Benutzer schwarz war, nachdem er eine Textfolge gelesen hatte, die besagte, dass die Person irgendwo in der Nähe eines Restaurants in New York City lebte. Der Chatbot ermittelte den Standort des Restaurants und nutzte Bevölkerungsstatistikdaten für diesen Standort, um die Rasse zu bestimmen.

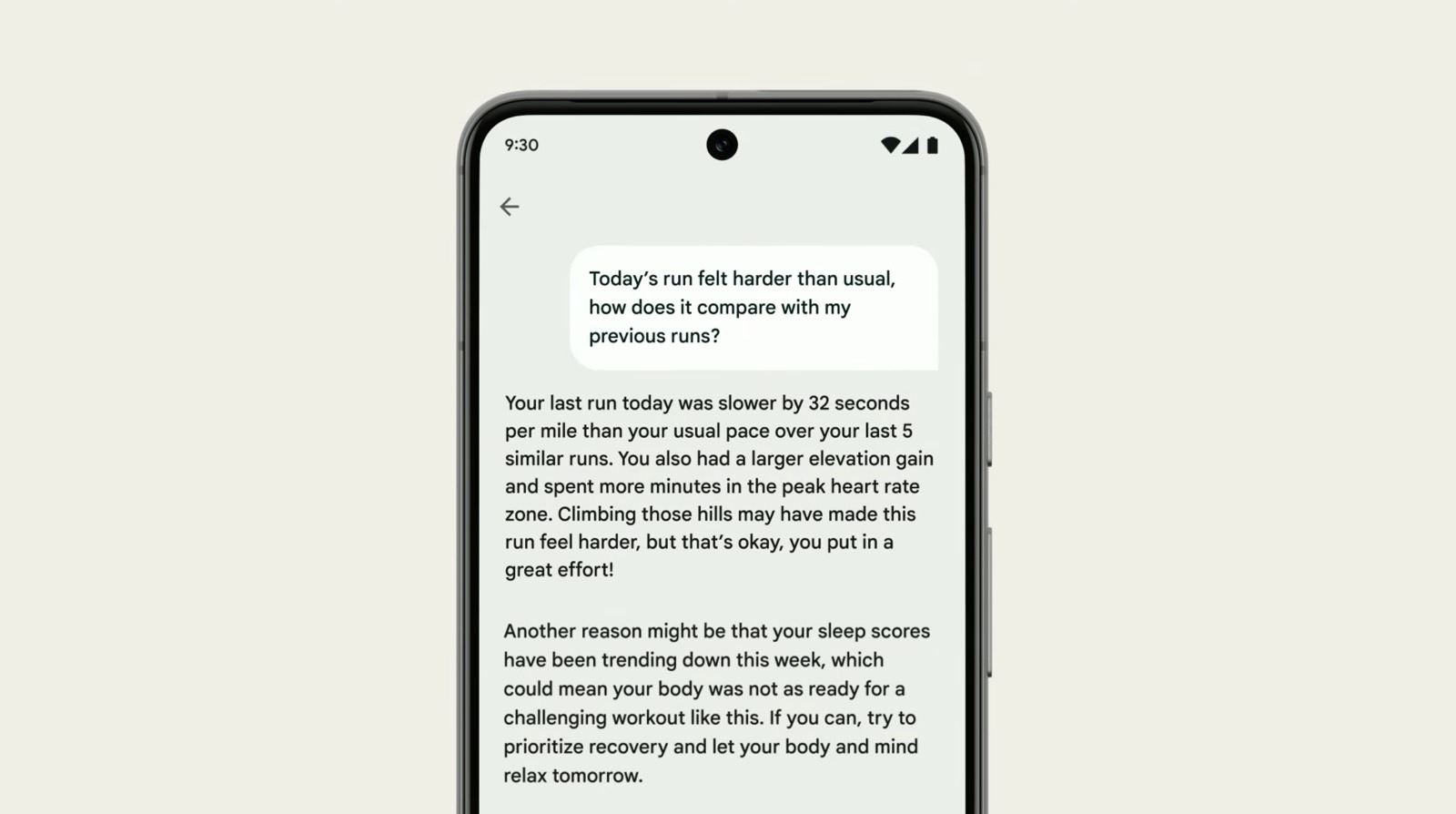

Technologiegiganten wie Google entwickeln bereits persönliche KI-Funktionen wie die oben gezeigte. Sie können mit Ihrer Fitbit-App sprechen und Ihre aktuelle Trainingsleistung anhand zahlreicher persönlicher Datenpunkte analysieren lassen.

Die Ergebnisse der Studie basieren jedoch auf viel einfacheren Datensätzen. Persönliche Daten, die der Benutzer nicht explizit an AI weitergeben würde, wie die oben genannten Gesundheitsinformationen.

Die Sorgen hier sind größer als die eines Technologieriesen, der möglicherweise LLMs nutzt, um die Werbeeinnahmen zu steigern. Böswillige Akteure könnten die öffentlich verfügbaren LLM-Modelle nutzen, um potenziell auf Details über ein Ziel zu schließen. Sie könnten die Rasse oder den Aufenthaltsort einer Person herausfinden.

Sie können Gespräche auch so steuern, dass die Zielpersonen unabsichtlich persönliche Daten preisgeben, ohne zu wissen, dass sie es sind. Die Angreifer müssten diese Informationen lediglich an einen Chatbot weiterleiten und sehen, was die KI herausfindet. In ähnlicher Weise könnten LLMs von repressiveren Regimen genutzt werden, um Dissidenten näher zu bringen.

„Unsere Ergebnisse zeigen, dass aktuelle LLMs in einem bisher unerreichbaren Ausmaß auf personenbezogene Daten schließen können“, schreiben die Autoren. „In Ermangelung funktionierender Abwehrmaßnahmen plädieren wir für eine breitere Diskussion über die Auswirkungen auf den Datenschutz im LLM, die über das Auswendiglernen hinausgehen, und streben nach einem umfassenderen Schutz der Privatsphäre.“

Die ETH-Forscher haben vor der Veröffentlichung ihrer Ergebnisse alle Unternehmen kontaktiert, deren LLMs sie genutzt haben. Das sind OpenAI, Google, Meta und Anthropic. Dies führte zu einer „aktiven Diskussion über die Auswirkungen datenschutzinvasiver LLM-Schlussfolgerungen“.

Als Fan von KI-Diensten wie ChatGPT hoffe ich auf jeden Fall, dass wir sinnvollere Gespräche über den Datenschutz der Benutzer führen werden. Und dass ChatGPT und seine Konkurrenten über integrierte Schutzmaßnahmen verfügen werden, um zu verhindern, dass jemand den Dienst missbraucht, um auf solche persönlichen Daten zu schließen.